Dlaczego Twoje linki nie działają ? Cz. I

Mniej więcej rok temu Google zatrzęsło ziemią wprowadzając nową wersję algorytmu Pingwin do walki ze spam linkami. W związku z tym, że w swojej codziennej pracy SEO dużą wagę przykładam do strategii link building’owej automatycznie stał się on celem moich analiz i przemyśleń.

Uważam, że zrozumienie tego algorytmu jest kluczowe jeśli chce się myśleć o poważnym link buildingu i liczyć na dobre efekty, a nie na przypadek. W poniższym artykule chciałbym podzielić się z Tobą moimi niespełna rocznymi przemyśleniami na temat tego z czym mamy obecnie do czynienia w Google.

Kluczowe informacji na temat Pingwina:

Najnowsza wersja Pingwina w przeciwieństwie do swoich poprzedników nie degraduje całych stron czyli nie wycina ich całkowicie z wyników wyszukiwania, jak to miało miejsce w poprzednich wersjach Pingwina. A jedynie dewaluuje je, a tak na prawdę dewaluuje linki do nich prowadzące!

Jest to kluczowe, ponieważ Pingwin jest algorytmem oceniającym linki, a nie podstrony do których one prowadzą. Dzięki temu podstrona A może nie być widoczna w wynikach wyszukiwania, a podstrona B już tak.

Następuje swojego rodzaju granulacja wyników per podstrony naszej strony (przypomnij sobie ile stron głównych było w wynikach wyszukiwania jeszcze rok temu, a jak dużo teraz jest w ich miejsce podstron).

Najprawdopodobniej Pingwin nie jest algorytmem działającym na zasadzie Trust Rank ani Topical Trust Rank (wygląda na to, że Google wcale nie stosuje tego typu metryk i jest to jedynie wymysł branży SEO i narzędzi SEO, którymi byle Pakistaniec (przepraszam) z łatwością manipuluje w celu sprzedaży super linków/domen). Nie jest to też żadna sztuczna inteligencja, co potwierdził Gary Illeyes w zeszłym roku.

Z pewnością fragmentem Pingwina jest analiza statystyczna stron i linków do nich prowadzących w obrębie branży/niszy/frazy, w której analizowana strona się znajduje. Wspominałem o tym w swojej prezentacji na spotkaniu SemKrk w 2017 r. Odniosłem się wtedy do patentu Google, który mówi:

Na przykład wynik wyszukiwania związany ze spamem może stanowić wynik wyszukiwania zasobów, dla których stosunek między liczbą linków, a liczbą opcji jest większy niż próg. Niektóre kategorie zasobów zawierają zazwyczaj więcej zasobów związanych z spamem niż inne. Na przykład wydawcy wielu witryn udostępniania wideo próbują manipulować rankingami, tworząc linki do stron, co powoduje nieproporcjonalnie dużą liczbę linków w porównaniu do liczby wybranych, a krajowe witryny z wiadomościami zazwyczaj nie próbują takiej manipulacji.

Reasumując algorytm może np. analizować sytuacje typowe dla stron spamowych, jak:

- procentowy rozkład anchorów

- procentową ilość linków do strony głównej vs. linków do podstron

- źródła linków

- przyrost w czasie

- typowe schematy spamerskie

- …

I statystycznie odnosić się to do wiedzy jaką ma na temat spamu. Ok – na pewno tak jest, ale to nie wszystko 🙂

Swoją prezentację zakończyłem kluczowym zdaniem „Spraw by Twoje linki nie były indeksowane, a brane pod uwagę”.

Wszystko wskazuje na to, że miałem rację i jest to kluczowe zdanie w celu zrozumienia istoty Pingwina – brawo Ja 🙂

A więc czym może być Pingwin?

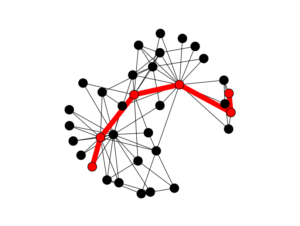

Informacje zebrane w Internecie wskazują na to, że Pingwin jest algorytmem wartościującym linki nie na podstawie trust rank, page rank etc. tylko dystansu jaki link prowadzący do naszej strony ma od najbliższego authority lub branżowego authority (seed). Google mówi o tym w swoim patencie https://www.google.com/patents/US9165040 (co ciekawe słowo distance zostało tam użyte 69 razy a np. trust 3) oraz https://www.google.com/patents/US8082246

„…a system that ranks pages on the web based on distances between the pages, wherein the pages are interconnected with links to form a link-graph. More specifically, a set of high-quality seed pages are chosen as references for ranking the pages in the link-graph, and shortest distancesfrom the set of seed pages to each given page in the link-graph are computed.”

Należy to rozumieć tak, że Google tworząc mapę Internetu (graf linków) zaczyna od seed’a, czyli np. od Wikipedii, Youtube, Onet etc. i w myśl tego patentu bada, jak daleko „w linkach” czy też w ilości przeskoków w grafie linków znajdujemy się od niej. Im krótszy dystans między seed’em, a naszą stronę – tym link zdobywa większą wartość.

W ostatnim czasie wiele razy słyszałem podobne stwierdzenia coś typu:

- „Puściłem blasta na 50 tys linków i nic ani w górę, ani w dół”

- „Założyłem 1000 profili Zenkiem (każdy z nich zapewne z ID 10000+ albo i lepiej) i nic ani w górę, ani w dół”

- „Dodałem linki do statlinka i nic. Usunąłem stare i w sumie też nic – ani w górę, ani w dół”

I wypowiedzi tych drugich:

- „Teraz to lepiej 10 dobrych publikacji, niż 1000 byle jakich linków”

Też to słyszałeś wiele razy, prawda ? 🙂

Ok! Zatem jak może być obliczany dystans linku, a tym samym jego wartość?

Mój serdeczny przyjaciel Damian Sałkowski na swojej ostatniej prezentacji w ramach Semkrk (https://www.senuto.com/przyszlosc-ktora-nadejdzie-jutro/ – co prawda na temat AI, z którą nie mamy tutaj do czynienia) powiedział, że Google dla każdej branży może losować inne czynniki rankingujące i mniej więcej tak jest w tym przypadku.

Google w swoim patencie pisze:

Generally, it is desirable to use large number of seed pages to accommodate the different languages and a wide range of fields which are contained in the fast growing web contents. Unfortunately, this variation of PageRank requires solving the entire system for each seed separately. Hence, as the number of seed pages increases, the complexity of computation increases linearly, thereby limiting the number of seeds that can be practically used… Hence, what is needed is a method… for producing a ranking for pages on the web using a large number of diversified seed pages without the problems of the above-described techniques.

Google nie tworzy zatem jednego wielkiego grafu całego Internetu (tak pewnie było przy pagerank). Było by to bardzo nieefektywne (aktualizacje page rank raz na rok albo i wcale, a teraz mamy podobno real time). Google w celu uproszczenia grafu linków i obliczeń generuje dla każdego języka oraz dla każdej z branż/tematów osobny graf z osobnym seed’em/authority od którego zaczyna liczenia przeskoków, a tym samym wartości linka.

Wartość linka określana jest na podstawie NAJKRÓTSZEJ ścieżki w grafie linków.

Tłumaczy to, co słyszy się w branży czyli np.:

- „Przeanalizuj linki konkurencji i dostosuj się do nich lub zrób takie same jak oni”

- „Nie wiem o co chodzi. Jedna strona mi wejdzie a inna nie, linki robię takie same – nie ma reguły raz działa, raz nie”

Znajome ? 🙂

Link distance zmienia całkowicie strategie linkbuildingową!

Wspomniane przeze mnie wcześniej zdanie powinno w tym momencie przyjąć nowe brzmienie, tak jak poniżej:

Spraw by Twoje linki nie były indeksowane, a brane pod uwagę ->Spraw by Twoje linki znajdowały się w grafie linków!

Ale to jeszcze nie wszystko! Google z tworzonego grafu linków musi eliminować spam – tworzy tak zwany zredukowany graf linków. Najprawdopodobniej tutaj jest całe sedno najnowszego Pingwina – optymalizacja zasobów, w dużym uproszczeniu taki crawl budget dla linków! (o tym następnym razem – jest coś takiego 🙂 )

Może się to odbywać np. przez określenie kierunku linków czyli np. strony spamerskie częściej linkują do dobrych stron, a strony dobre do spamerskich raczej nie linkują.

Na podstawie np. analizy statystycznej oraz kierunku linków (oczywiście czynników decydujących jest zapewne znacznie więcej) Google usunie strony spamerskie ze zredukowanego grafu linków, czyli w żaden sposób nie bierze ich pod uwagę. Tym samym nie mogą one skrzywdzić ani pomóc stronie linkowanej. Negatywne SEO praktycznie przestało istnieć. Więcej na ten temat : http://www2007.org/workshops/paper_125.pdf

Dokładnie to miało miejsce po wprowadzeniu Pingwina – strony obniżyły swoją pozycję/widoczność, a nie straciły ją całkowicie – zabrakło dobrego paliwa.

Tłumaczy to również, dlaczego pracownicy Google poinformowali, że po wprowadzeniu Pingwina nie trzeba używać narzędzia disavow – bo i niby po co skoro niskiej jakości linki, które by się znalazły w pliku disavow i tak poziom wyżej – nie są brane pod uwagę. Wszystko wskazuje na to, że spamerskie linki nie mają obecnie ani pozytywnego, ani negatywnego działania dla dobrych stron znajdujących się w zredukowanym grafie linków.

Podsumowując albo znajdujesz się ze swoją stroną i stronami linkującymi w zredukowanym grafie linków, którego pilnuje Pingwin albo nie będziesz w stanie pozycjonować się na jakiekolwiek odrobinę trudniejsze słowa kluczowe.

Powyższe przemyślenia tłumaczą również, dlaczego obecnie na zachodzie coraz więcej mówi się na temat testowania linków, metod takich działań oraz ich pozytywnego lub negatywnego wpływu.

Tłumaczą również czas, który obecnie jest potrzebny by cokolwiek zdziałać – tzw. sandbox czy raczej real time pingwin, który wpuści Cię do zredukowanego grafu linków ? (Wydaje mi się, że to ten dzień, w którym wszyscy chwalą się na grupach SEO, że „u mnie na zielono”)

Będzie mi bardzo miło opowiedzieć Ci o tym i innych super rzeczach następnym razem.

Tyle na dzisiaj. Jeśli Ci się podobało – zapraszam do zapisania się do mojego newslettera, by nie przeoczyć kolejnego wpisu.

Jeśli chcesz poczytać dalej moja inspiracja

64 Comments

Może w cz II wpisu poruszysz temat metod analizy linków dostosowanych już do pingwina?

Tak jak piszesz: „Nie wiem o co chodzi. Jedna strona mi wejdzie a inna nie, linki robię takie same – nie ma reguły raz działa, raz nie” – ostatnio tak jest.

„Spraw by Twoje linki znajdowały się w grafie linków!” – czyli najlepiej jak link do strony znajdzie się np. tam gdzie link konkurencji?

„„Spraw by Twoje linki znajdowały się w grafie linków!” – czyli najlepiej jak link do strony znajdzie się np. tam gdzie link konkurencji?”

Na pewno warto analizować backlinki do konkurencji, ale nie tyle w celu naśladowania ich działań (nie zawsze są warte naśladowania 😉 ), co w celu wyłapania perełek wśród źródeł linków.

Rozumiem, dzięki Lexy 🙂

Ja często dzięki analizie konkurencji znajduję ciekawe miejscówki.

Trzymam kciuki za rozwój bloga. Ciekawy wpis 🙂

Merytoryczna wiedza + rzeczowe przemyślenia w polskiej branży SEO? Muszę sobie ten dzień zapisać w kalendarzu. Od dziś firmy SEO będą wiedzieć czym się zajmują i o co w tym chodzi.

Twój artykuł w znaczącym stopniu odzwierciedla to, co się dzieje. Jednak nie zgodzę się, że „słabe” linki nie mogą zaszkodzić, ani pomóc. Zdarzyło mi się, że dla testów podlinkowałam prawdopodobnie domenę z filtrem dziesięcioma katalogami. Na kilka fraz zanotowałam spadki i nic więcej… Wiec to jest raczej loteria lub wszystko zależy od branży 😛

Już szeruję 🙂

Nie kumam tego „dystansu”, jak mam seeda w postaci YouTube, to jak mam określić jak daleko jestem od niego albo inaczej co powoduje że przybliżam się? Jak YouTube linkuje do mnie to przybliżam się ?

Pozwolę sobie zacytować komentarz który umieścił Łukasz Rajzer na Fanpage Senuto (https://www.facebook.com/SENUTOtool):

„Swego czasu miałem przyjemność rozmawiać z współtwórcą polskiej wyszukiwarki robionej na uczelni wyższej. Ich założeniem było również ręczne nadanie początkowych autorytetów dla poszczególnych kategorii.

Tak w zasadzie działał początkowo Google.

Dziś z racji mnogości serwisów wspiera się ludźmi.

Ja nie przyjmowałbym, że Onet czy Wiki są tymi na górze. Winne być to serwisy, które specjalizują się w danej tematyce i są fachowe, autorytatywne i niezależne. Zaryzykowałbym stwierdzenie, że nie tylko dbaj o to, by wpaść do grafu, ale spróbuj stać się jednym z jego wierzchołków.

Tu wiek domeny nie powinien grać głównej roli, a rodzaj i jakość treści oraz ich ocena przez inne wierzchołki lub serwisy im bliskie.”

Ta teoria pozbawia sensu budowania stron zapleczowych i linkowania ich z czego popadnie (bo przecież o mocy zaplecza świadczy liczba kierujących do niego linków ;). Bo jaka jest szansa, że taka zapleczówka wskoczy w graf linków i linki na niej publikowane będą przekazywały moc na średnio trudne i trudne frazy? Świetny wpis 🙂

Ta teoria nadaje sensu budowanie zaplecz. Ta teoria tłumaczy fenomen i skalę zjawiska PBN i expired domain na zachodzie. Pozdrawiam.

Nie tylko na zachodzie. W pl mamy niezłe PBNy tyko nie każdy o nich wie.

Trzeba linkować zaplecza z wartościowych miejscówek

Panie Robercie bardzo ciekawe spojrzenie na temat linkbuildingu. Chętnie poczytałbym więcej na ten temat. Kiedy można liczyć na kolejne publikacje w tym temacie?

Najpierw piszesz, że nie ma znaczenia negatywne seo i słabe linki, zeby potem:

Powyższe przemyślenia tłumaczą również, dlaczego obecnie na zachodzie coraz więcej mówi się na temat testowania linków, metod takich działań oraz ich pozytywnego lub negatywnego wpływu

Przy negatywnym SEO miałem na myśli linki stricte spamerskie z Xrumera etc. Przy testowaniu miałem na myśli testowanie expired domain i pbn. Chętnie to opisze w kolejnych postach bo to długi i obszerny temat nie na komentarz ew. zapraszam na priv.

Rozumiem, potwierdziłes moje przemyślenia. Dzieki za art!

Ciekawy wpis. Będę zaglądał.

Dobry i ciekawy wpis 🙂 Trend ktory opisujesz jest w mojej ocenie pozytywny dla branży

Świetny wpis:)

Czyli jak widać nabiera znaczenie struktura linków do całej strony, linkowanie nie tylko głównej ale i podstron.

Z tego powodu właśnie przy obecnym algo powoli wypierane są LP onepage.

Co do linków, nic tylko szukać expirek które są podlinkowane z domen seed:)

Czy ten wpis jest poparty badaniami/testami? Brzmi logicznie, ale nie do końca jest to zbieżne z moim doświadczeniem… bo wg tego w najprostszej linii język witryny powinien odgrywać kluczową rolę… dobrze rozumiem?

Konkretne przemyślenia – Tak trzymaj! Blog ląduje w zakładkach 🙂

Świetny i ciekawy wpis. Tym wpisem potwierdziłeś moje przypuszczenia odnośnie Pingwina. Czekam na ciąg dalszy

Analizując powiedzmy piątkę największych konkurentów warto zweryfikować kombinacje dwóch, trzech czy czterech ich wspólnych czynników rankingowych, zamiast analizować każdego osobno i stosując kilka oddzielnych strategii.

Ciekawa teoria, ma to sens.

Nasuwają się pytania/przemyślenia

1) jak znaleźć strony, które już są w grafie linków? (tak, analiza linków konkurencji i wybieranie z nich dobrych miejscówek to metoda, ale nieoptymalna)

2) z jednej strony „wiek domeny nie ma aż takiego znaczenia”, a z drugiej, według tej teorii – czy jest sens stawiania zaplecz na nowych domenach, które nie miały w przeszłości styczności (linków z) seed domains?

3) skoro „negatywne seo” nie działa, tzn. że opłaca się „walić linkami na ślepo”, bo a nuż któraś z miejscówek będzie gdzieś w grafie linków?

1) Metod zapewne jest wiele. Pierwsze co nasuwa mi się na myśl to po prostu sprawdzać widoczność strony gdzie chcemy się linkować. Jeśli jest dodatnia/przyzwoita to link zadziała. Jak jest zero lub blisko zero a contentu nawalone – nie będzie efektu. Tutaj dla zobrazowania można popatrzyć na zaplecza z swl, jakieś stare precle etc. niby parametry tf dr mocne i nic więcej.

2) Jest ale wtedy trzeba liczyć się z czasem potrzebnym by ta domena miała wartość.

3) Tutaj my rozmawiamy tylko o pozytywnym SEO 🙂

1) Hmm tak sobie myślę że jeśli domena na dane zapytanie jest powiedzmy w TOP100 wyników wyszukiwania to raczej chyba ma jakąś wartość dla googla i znajduje się w grafie linków.

Ja tylko dodam do pyt. 2, że moim zdaniem warto mieć postawione zaplecza zarówno na nowych, jak i „odświeżonych” domenach. Na odświeżonych wtedy, kiedy tematyka nam bardzo ładnie podpasuje. Wtedy wystarczy postawić stronkę o podobnej zawartości i zoptymalizowaną w co najmniej tak dobrym stopniu jak dawna wersja (albo i lepiej), aby wskoczyła na sensowne pozycje i zarazem wyższe niż te, na które można się dostać z zupełnie nową domeną. Trzeba tylko zwrócić uwagę na to, jakie linki do nich prowadzą, żeby nie zrobić sobie pod górkę beznadziejnym profilem linków.

To tak nie działa. Zaplecze o widoczności bliskiej 0 potrafi kopać jak szalone. Parametry TF, CF nie mają tutaj nic do rzeczy.

Ok ale ja o tym nie pisałem 🙂 Ale dzięki za komentarz. Zgadzam się z Tobą.

Spoko wpis – z grubsza to Google komunikuje już od dawna. Czyli teraz przydałoby się narzędzie, które bierze top „n” serwisów z taksonomii google’owej (z danej branży np: Nieruchomości) pod kątem popularności (czyt. do ilu użytkowników możesz potencjalnie dotrzeć poprzez reklamę Adwords) i mamy listę popularnych branżowych stron. Do tego wszelkie analizy linków wychodzących z tych serwisów + analizy linków konkurencji i finalnie otrzymujemy graf linków czyli narzędzie, którego nikt nie ogarnie 🙂

Teraz Damian Salkowski niech do senuto napisze moduł który symuluje graf linków. Na podstawie widoczności soft typuje seedy w danej branży i dalej ocenia odległość od nich a co za tym idzie – przybliżona moc strony. Robert Niechciał mojego maila już masz, na testy chce mieć moduł jako jeden z pierwszych! 🙂

Bardzo dobry wpis, jeden z lepszych jakie czytałem w ostatnim czasie. Kładzie nowe światło na linkbilding. Życzę powodzenia w tworzeniu bloga i czekam na kolejne wpisy.

Bardzo dobry wpis. Jednym zdaniem trzeba dbać o jakość linków, a dobre linki kosztują 🙂

Blog zapowiada się ciekawy 😉 ale w teorię że nie można sobie zaszkodzić linkami to nie wieżę.

Coraz częściej firmy SEO piszą do moich klientów z pytaniem czy jest możliwość wstawienia linka z głównej strony za opłatą, tak szukają dobrych linków dla swoich klientów.

Witaj! właśnie zaczynam swoją przygodę z SEO i taki blog na pewno mi się przyda. Będę częściej zaglądała. Pozdrawiam !

jak zalinkuje ze strony zapleczowej do authority/seeda to mój dystans zyskuje wartość=1 i jestem bogiem seo ? Panie i Panowie złamałem algorytm google.

Brawo 🙂

świetny wpis! oby tak dalej, skuteczny link building staje się coraz większą zagadką 😉

Jeżeli trzymamy się twojej obserwacji/teorii to jest jakiś graf ze stronami, w danej tematyce. OK – przyjmijmy go za pewnik. Nasuwają się pytania: Skoro mam naśladować konkurencję, to na jakim grafie była moja konkurencja, zanim zaczęła linkować?

Obecnie jest szał na świerzaki. Skąd będziesz wiedział, że ta dana strona jest w grafie tematycznej ze świerzakami? Na podstawie czego ja/ty mamy o tym wiedzieć, gdy to jest powiedzmy nowa kategoria/tematyka?

Piszesz o zbiorze stron w danej tematyce, ale kto był pierwszy w takim grafie? Wikipedia?

Według twojej obserwacji, kluczem jest odnalezienie odpowiedniej ścieżki grafu stron, które mają być przyporządkowane w danej kategorii, niestety teoria ta upada, gdy powstaje jakaś nowa, zupełnie nieznana tematyka, jakiś mega nowy trend – szal na coś. Wtedy, jak to jest liczone, skoro nie ma jeszcze stron w danym grafie?

Myślę że troszkę przekombinowałeś. Chętnie porozmawiam prywatnie na ten temat.

Może to ma jakiś sens co piszesz ale linki ze spamu tez działają. Mam stronę na której tworze dowolną podstronę, linkuje ją linkami ze spamu i idzie w topy jak burza, domena ma wysokie pozycje, jeśli tymi linkami potrakowalem inne domeny nie ważne czy nowe czy stare, to po wielu miesiącach nie drgnęły! Zeby linki działały domena musi dostać „trusta” zwał jak zwał ale takie coś to jest że domena dostaje kopa wtedy takiego że wszystko idzie na zielono to może być ten time o którym piszesz

Dzięki za wpis, kolejny powinien zawierać praktyczne przykłady na poparcie koncepcji 😉 Zgadzam się z tym, że obecna zawartość indeksu stanowi wskazówkę dla planowania link-buildingu.

Dzięki. Postaram się w najbliższym czasie przygotować adekwatny do tematu case

[…] Wiedza o liczbie linków wychodzących ze strony, która ma też linka do nas może okazać się przydatna. M.in. można wywnioskować, dlaczego niektóre strony z naprawdę niewielką liczbą linków przychodzących rankują całkiem dobrze. Dobrze będzie połączyć te dane ze wskazówkami, które na temat budowania linków podał Robert. […]

No tak, teraz tylko trzeba stworzyć narzędzie do skutecznej analizy linków… Niestety większość obecnych opiera się o ahrefs, Moza itp, które mają się nijak do wyników w G.

Blog już na speed dialu, zobaczymy co z tego będzie 🙂

naprawdę piszemy razem. Pozdrawiam

Serdeczne dzięki za wartościowy artykuł – swoją drogą liczba komentarzy i zaangażowanie czytelników powinny być dla Ciebie sporą motywacją, aby popełniać kolejne treści w podobnym, merytorycznym stylu na co – nie ukrywam – i my osobiście liczymy :).

Drobna sugestia – aby z samą treścią dotrzeć do szerszego grona osób na pewno warto opisywać szerzej same definicje – tutaj np. graf linków lub dystans linku. Chodzi zwyczajnie o to, aby osoba która niekoniecznie urzęduje w branży SEO na co dzień była też w stanie się połapać.

Raz jeszcze dzięki i z niecierpliwością czekamy na kolejne wpisy!

Artykuł profesorski, ale jak google miało by określać seeda dla branży / niszy ?

Dobry artykuł

Super wpis Robert 😉 mialeś racje w Brighton aby go przeczytać

Wspomniana wcześniej analiza konkurencji mimo wszystko jest kluczowa i może służyć pomocą przy analizie seed’ów. Seedy seedami ale tematyczność nie ma już znaczenia…?

Wg. mnie tematyczność w ujęciu offsite nie jest kluczowa. Tematyczność oraz pokrycie tematu onsite już tak.

Robert kiedy II część?

Kolejny artykuł będzie w poniedziałek 23 października. Jest już napisany ale czekam na „dobry moment” 🙂

Fajny art, idealny dla „domorosłych seowców” 😉

To zachęta do tego, żeby wyszukiwać wartościowe i tematyczne miejsca do linkowania, zamiast korzystać z budowania profilu linkowego w oparciu o listy z wysokim TF i CF. Na pewno się to opłaca, bo algorytmy są coraz lepsze, więc z pewnością będzie to miało coraz większe znaczenie.

Spam musiał być ukrócony, za dużo automatów powstało i jak cała branża zaczęła walić linkami to zrobił się z tego niezły bajzel do ogarnięcia. Teraz jak spam linki nie działają to nikt ich nie będzie tworzył, jak komuś coś wejdzie spamem niechcący to i tak kwestia czasu i wylot.

Dziękuję za ten artykuł. Pozwolił mi zrozumieć czemu pomimo ogromnego wysiłku i nakładów w link building domena ciągle spada.

Niemniej teraz po prostu nie wiem jak to robić dobrze, po prostu już nie mam pomysłu…