Dlaczego Twoje linki nie działają ? Cz. II

🤖 Crawl budget per IP

Dziś będzie krótko, ale mam nadzieję, że konkretnie. Chciałbym podzielić się z Tobą moimi kolejnym przemyśleniem w temacie SEO. W trakcie zbierania i analizy materiałów do poniższego wpisu okazało się, że jeszcze nikt na świecie nie poruszył tematu crawl budget w taki sposób – to takie moje małe odkrycie 🙂

W poprzednim artykule (klik) wspomniałem o temacie crawl budget dla linków. Problem pojawił się w mojej głowie w momencie, w którym okazało się że kilkaset domen PBN (strony zapleczowe na domenach wygasłych z dobrymi parametrami, linkami i historią) na których pracuję z jednym z moich klientów nie gwarantowało wprost topowych miejsc dla interesujących nas fraz.

Skalowanie ilościowe na tym poziomie było już bez sensu, tak więc szukałem rozwiązania swojego problemu gdzie indziej. Globalnie problem pojawił się w grudniu 2016.

❓Co to jest crawl budget

Crawl budget to pojęcie, które pojawia się w kontekście optymalizacji struktury stron internetowych (onsite).

🙋 Szybko i na temat

Założenie jest takie że crawl budget to czas lub ilość zapytań, które robot Google zada Twojej stronie w trakcie jej indeksowania. Im strona lepsza tym Google poświęci jej więcej czasu, im słabsza mniej lub wcale (czynnik jakościowy).

Dochodzi do tego jeszcze czynnik techniczny, czyli np. wydajność serwera (prędkość jego odpowiedzi, pierwszy bit danych – techniczne seo itd.). Google automatycznie ograniczy prędkość by nie zaszkodzić Twojej infrastrukturze jeśli jest słaba.

Zatem im strona/serwer lepszy tym robot google jest w stanie zadać jej więcej zapytań w procesie indeksowania – proste i logiczne.

Tak więc mamy tylko 2 czynniki określające crawl budget:

1. Czynnik jakościowy

2. Czynnik techniczny

Analizując dalej sposób w jaki Google przypisuje „wartość crawl budget” okazuje się, że jest ona przypisywana również do adresu IP serwera!

Łącząc tą wiedzę na temat crawl budget z podejściem do optymalizacji zasobów, które Google skutecznie wprowadza (część opisałem w poprzednim artykule – klik) pokusiłem się o następującą tezę:

Google praktycznie nie crawluje lub ma w nosie adresy IP/zasoby, które charakteryzują się niską wartością jakościową (contentem) oraz słabymi parametrami technicznymi.

A wprost w ujęciu „crawl budget per ip” brzmi to tak:

Google ma w nosie np. seohostingi, które są wylęgarnią spamu i na tych samych adresach IP stoją tysiące nikłej jakości stron (czynnik jakościowy). Dodatkowo zazwyczaj np. seohostingi są wolne i często rzucają błędami z serii 500 (czynnik techniczny)

📌 Przykład

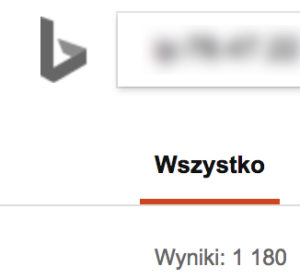

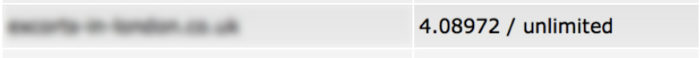

(Przykład dla pierwszego lepszego IP jaki wpadł mi pod rękę – 1180 domen jakości spam)

Analizując dalej mój przypadek okazało się, że bardzo dużo domen, które trzymałem w różnych śmiesznych miejscach o parametrach i klasie jak powyżej nie ma w raporcie linków w GSC (Google Search Console) a doskonale wiemy, że link niezaindeksowany nie istnieje. SZOK !

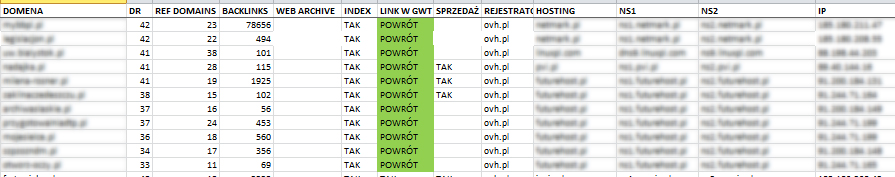

A więc ruszyłem z przenosinami PBN na własne prywatne zasoby serwerowe

Efekty były niemalże natychmiastowe (7-14 dni). Strony, których nie było w raportach GSC (a linki były na nich od wielu miesięcy) z dnia na dzień się tam pojawiły.

(Najważniejsza kolumna to „LINK W GWT” – stara szkoła SEO… GWT=GSC)

Mógłbym tak wklejać jeszcze bardzo długo… Praktycznie wszystkie domeny przeniesione zostały wzięte pod uwagę w raporcie Google Search Console.

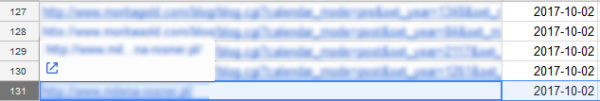

Dodatkowo pokusiłem się o sprawdzenie transferu (w tym przypadku jest on równoważny z ilością odwiedzin google bota) jaki został wygenerowany przez stronę zapleczową przed i po przenosinach (w takim samym czasie).

📌 Przykład

Przed migracją

Po migracji:

![]()

(Wartości pokazują transfer miesięczny w mega bajtach)

Oczywiście praktycznie wszystkie roboty analityczne typu Ahrefs, Majestic są wycięte. Stronę odwiedza tylko Googlebot lub człowiek. Dodatkowo profil linków nie uległ zmianie.

Te same obserwacje i wnioski ma również mój dobry kolega Wojciech Matuła z firmy linkjuice.pl.

Jakiś czas temu w tak zwanych kuluarach podzieliłem się z nim tym tematem i również wdrożył u siebie moje przemyślenia. To właśnie jego screeny widać wyżej (w tym przypadku wolałem potwierdzić na danych osoby trzeciej).

W krótkim czasie tylko po przenosinach były widoczne efekty w wynikach wyszukiwania.

🔗 Przykładowa fraza

(Fraza z kategorii trudniejszych lub bardzo trudnych)

Tak więc:

❤️ Wnioski

45 Comments

Jakbyś mógł podzielić się informacją, lub napisać mniej-więcej ile stron przeniosłeś i na ile różnych serwerów? Chodzi mi o to, czy, załóżmy, miałeś 100 stron i przeniosłeś je na 2 różne serwery czy raczej na 20 różnych serwerów? Jak z aktualnymi IP tych stron zapleczowych, czy się pokrywają? I ostatnie pytanie – jakie serwery polecasz do takich działań? Z góry dziękuję za odpowiedź

Kilkaset stron na kilkaset prywatnych adresów IP.

Dzięki Robert za odpowiedź. Pozdrawiam

Hmm, a podasz jakieś sprawdzone hostingi warte uwagi? i czy 1 hosting = 1 strona czy można kilka?

Wybacz ale nie. Seohostingi były tylko przykładem na potrzeby artykułu 🙂

Z tego wynika, że lepiej mieć swój własny hosting z dobrym zapleczem niż seo

Super artykuł

Mega tekst, ale SEO hostingi się chyba obrażą 🙂 Nie mogę doczekać się kolejnego.

Ilona: seohostingi się nie obrażą. Z proste przyczyny: niewielu stać na ilka dedyków czy VPSów, które sa dobrze podrasowane

Bardzo interesujący wpis 😉 Możesz pochwalić się jaką komendą sprawdzasz w bingu ilość stron postawionych na danym IP? 😉

ip:X.X.X.X

localhost’em ich 😀

Jeden z niewielu newsletterów na jakie się zapisałem. Well done 😉

Ten artykuł to tylko kolejne potwierdzenie tego, że SEO Hostingi to słaby pomysł na zaplecze, ale myślę, że każdy kto poważnie podchodzi do tematu dywersyfikuje adresy IP, dane rejestrowe itd. Brawo za przedstawiony case –

bardzo rzeczowy i konkretny, szybko się czytało zgodnie z obietnicą 🙂

Bardzo dobry artykuł. Uważam, że tego typu szczegóły sa szczególnie istotne w najbardziej konkurencyjnych branżach.

Dziękuję bardzo. Zdecydowanie tak jest 🙂

Czy polecasz do takich zabiegów narzędzia takie jak Rocket IPs?

Dałeś mi do myślenia, musze się zastanowić nad strukturą naszego zaplecza. dzieki!

Nie do końca rozumiem , jak zmiana adresu hostingu miałaby sprawić, że Twoje domeny wcześniej wykluczone z grafu linków, miałyby do niego wejść? Bo czytając Twój poprzedni wpis, zrozumiałem, że to na tym należy się koncentrować?

Taktuj to jako 2 osobne tematy. Graf linków – poziom ignorowania linków do twojego zaplecza. Serwer i adresacja IP – poziom ignorowania Ciebie 🙂 W następnym poście idziemy poziom wyżej 🙂

Przeniosłeś już wszystkie strony czy coś jeszcze zostało? 😉

Interesujące może być podpięcie stron, które leżą na badziewnym seo-hostingu pod np. cloudflare. Wtedy na pewno wzrośnie czas ładowania strony (cache po strone CF) i dnsy też będą inne.

Może jakiś pomysł na wyizolowanie czynników – osobno czas ładowania strony i osobno IP? Zastanawia mnie, który z tych czynników jest bardziej istotny.

Praktycznie wszystko zostało już przeniesione. Cloudflare jak najbardziej tylko zwróć uwagę że będziesz miał wszędzie te same dnsy i w certyfikacie ssl który da Ci Cloudflare będą wszystkie twoje domeny 🙂 Tak czy siak warto testować. Powodzenia!

Cloudflare to taka trochę budżetówka. Zagraniczni sełowcy polecają nie przekraczać 25% pbnów puszczonych przez cloudflare-a. Robert marna to pociecha ale cloudflare korzysta z kilku dnsów dobieranych losowo.

Świetny artykuł i niesamowita dedukcja 🙂 Zaplecze postawiłeś na dedyku + domeny czy szlachtowałeś się z dobieraniem budżetowych hostingów?

Ja akurat mam to na usłudze z kategorii cloud. Wojtek z linkjuice.pl zrobił to na budżetowych hostingach – efekt ten sam

Tutaj muszę się nie zgodzić, do CF mam z 60 domen podpiętych i wszędzie inne DNS. Średnio na IP jest 80-150 domen. Dobrze podpięte domeny pod CF praktycznie są nie do wykrycia (skąd są podpięte). CF ma takie ilości IP że można z krzesła spaść i zawału jeszcze dostać więc o „złe sąsiedztwo” też raczej bym się zbytnio nie martwił, nawet jak jest problem to zmiana kolegów to dodatkowe kilka minut. Generalnie nie testowałem takiej zmiany seohost->dobry host->cf, ale jest motywacja żeby coś podziałać.

Dzięki za wpis, dobry post.

Jak sprawdzić jakość domen na danym serwerze?

W bing wpisz ip:204.79.197.200 …

Powinniśmy stworzyć system wymiany serwerami, czyli na hostingu zazwyczaj mamy możliwość postawienia kilku stron, wymieniajmy się tym miejscem

A jeśli jest jakiś „seohosting” z nazwy, załóżmy, tak reklamowany – i ma się na nim wiele domen (ale na różnych IP wszystkie) również może być to problem?

Inaczej zapytam – czy Google skądś „wie” na jakim hostingu stoi jaka strona? Jeśli tak, skąd?

Bo jeśli nie wie – to siedzenie na jednym hostingu pod warunkiem posiadania wielu ip nie powinno być problemem.

A jeśli wie… to ciekawe skąd?:)

Robert nie ważne jest ile ty masz domen tylko ile jest ich w sumie na tym jednym ip.

1. Ile wyników powinno zwrócić Twoim zdaniem zapytanie w Bingu ip:200.28.290.200 by można mniemać, że „ip jest zaspamowane”?

2. Czy przeliczałeś o ile wzrosną koszty utrzymania około 100 PBN po przejściu na budżetowy hosting?

3. Czy możesz zdradzić ile budżetowych hostingów zostało użytych do hostowania tych 100 PBN?

Poza tym świetny artykuł 🙂

Dużo domen na IP nie znaczy, że IP jest zaspamowane 🙂

Interesujące testy. Dobra robota, naprawdę przyjemnie i lekko to się czyta.

Robert, to zrób jeszcze test i przenieś te kilkaset domen na jeden IP 🙂

Po co?

Polecam rozwiązanie jakie wdrożylem n nas 3 lata temu – sieć serverów VPS w konfiguracji reverse proxy, + zaplecze fizycznie na jednym dedyku. Mamy i dywersyfikację C klas/ASów na VPSach i wygodne zarządzanie większą ilością stron na jednym serverze.

Bardzo dobry artykuł. Trzymasz poziom – pierwszy artykuł z tej serii był świetny, ten jest świetny – czekam na kolejne.

Jak to sie ma w przypadku duzych serwisów +200k podstron w przypadku gdy wersja mobilna m.domena.pl i wersja desktopowa http://www.domena.pl stoja na 1 ip. Czy warto wydzielic osobne IP dla wersji mobilnej celem zwiekszenia crawl budgetu per IP abstrahujac zupelnie od linkowania.

Nie umiem odpowiedzieć. Nie prowadziłem takich testów. Warto sprawdzić ale jeśli m.domena.pl i domena.pl są ok myślę że dobrym krokiem będzie zapewnienie im 1 dedykowanego ip i tyle.

W końcu druga część długo wyczekiwanego artykułu. Co do IP to sam nie odnotowałem tego typu zjawiska choć mam część stron na współdzielonych IP i wszystkie indeksują się świetnie.

Przede wszystkim przy pozycjonowaniu i planowaniu zaplecz – mierzmy siły na zamiary 🙂

Jak sądzisz – czy można postawić zaplecze na około 200 blogów, używając reverseDNS postawionym na 10 różnych serwerach VPS? Daje nam to 1 ip na 20 blogów. Wystarczające?

Witam,

kiedy można spodziewać się kolejnego wpisu. Twoje poprzednie publikacje były świetne.

Czekam z niecierpliwością.

..to tylko dorzucę, że działa, długo po czasie publikacji 😉 dzięki Robert za art! 🙂

Ciekawy test. Najlepiej byłoby każde zaplecze postawić na osobnym dedyku – czuję, że większość osób po sprawdzeniu cennika nawet nie podejmie takich prób…